Stanislav Belyaev

Empowering Teams, Advancing Engineering

AI делает нас тупыми

Заголовки, которые в среду наполнили мою ленту. Вышло исследование от Microsoft Research в коллаборации с институтом о влиянии использования инструментов GenAI (типа ChatGPT) на критическое мышление оператора (здесь краткое изложение). Но такой заголовок длинный, поэтому использовали желтый заголовок, которые многие репостнули. Такие издания как TechCrunch сделали приписку в конце все же, о чем это исследование.

Этот эффект я на себе испытал еще 1.5 года назад, когда писал об использовании AI в работе. Основные же идеи из исследования:

- Чем больше люди доверяют AI, тем меньше шансов, что они критически отнесутся к результатам

- Чем проще задача, тем менее вероятно операторы будут перепроверять результаты

- Работа смещается с “найти информацию” на “перепроверить информацию и источники”

- Чем больше оператор уверен в себе, тем выше шанс, что он критически отнесется к результатам AI

- В условиях ограниченного времени доступного на решение задачи, критическое мышление отключается

- Отсутствие знаний в доменной области, не дает возможности оператору критически отнестись к ответам AI и понять, что они могут быть неточны.

- Уверенные в своих скилах специалисты (у них есть знания, опыт) могут перепроверить результаты из их доменной области и уже критически отнестись к ответу. Но не иначе.

При этом, AI дает “средние” ответы. Если человек принимает без изменений ответы от Chat GPT, то он становится “средним”, поскольку теряется уникальность, креативность человека (того, кто думает, придумывает, создает). Люди не придумывают аргументы, почему это сработает, а “просят AI дать аргументы для их тезиса” или “найти подтверждения их гипотез” (вместо валидации и улучшения).

Согласно исследованию, работа людей, с использованием AI смещается с “придумывания идей” на то, чтобы “контролировать и валидировать ответы от AI”. Ответы вынуждают операторов идти и проверять все источники и все факты, с которыми пришел AI.

Простота использования искусственного интеллекта может склонить даже опытных профессионалов к менее строгому контролю. И сделать их “средними”, такими как многие другие. Но откуда должна прийти новая идея?

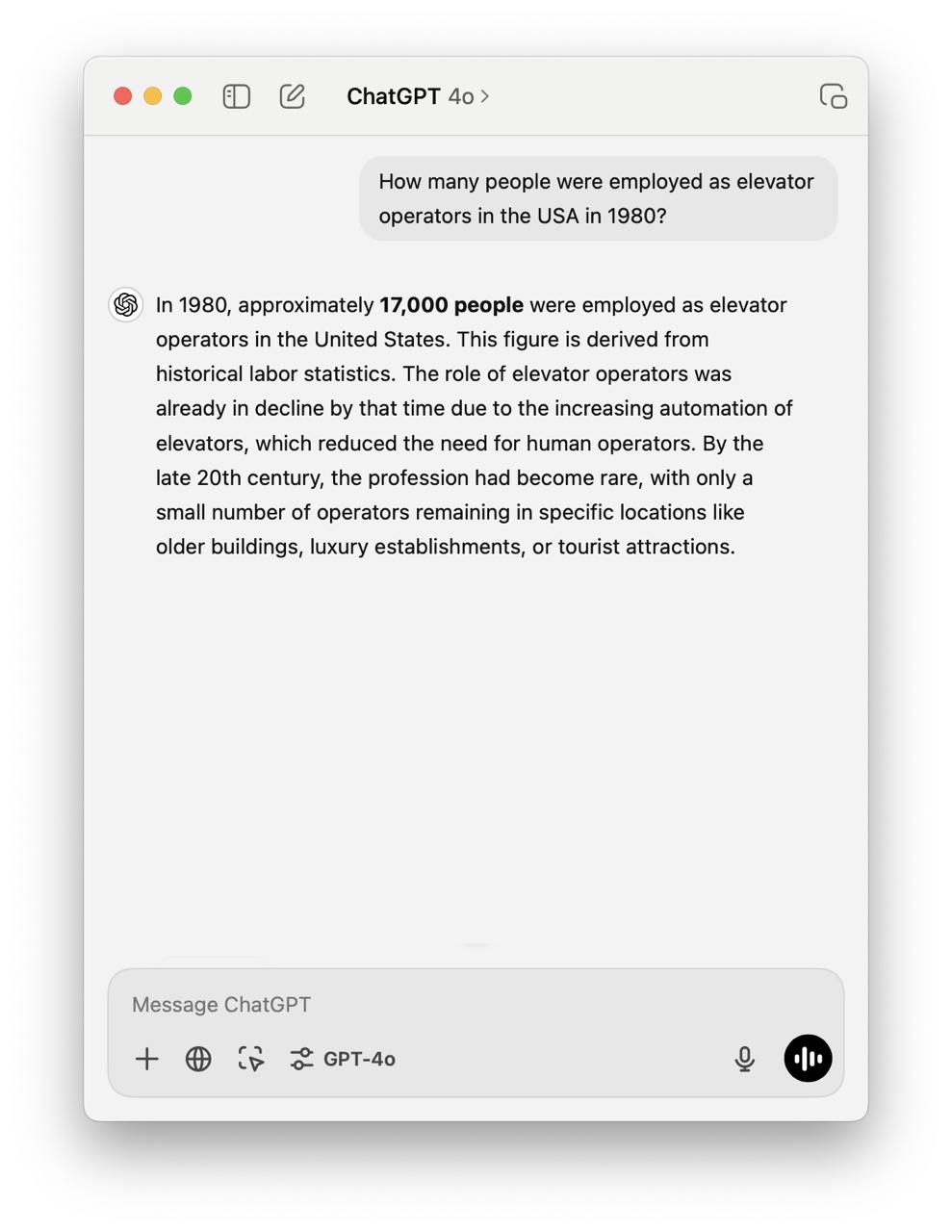

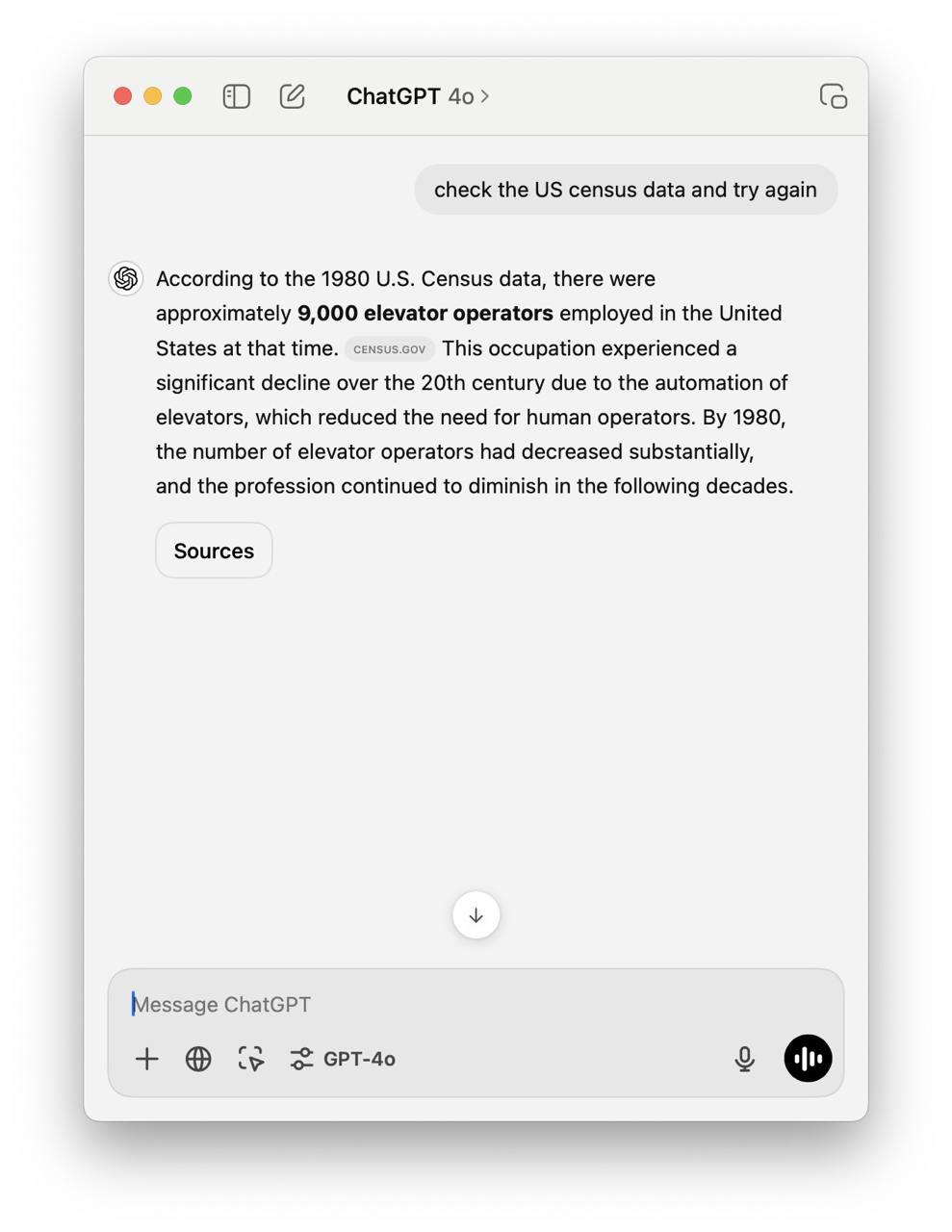

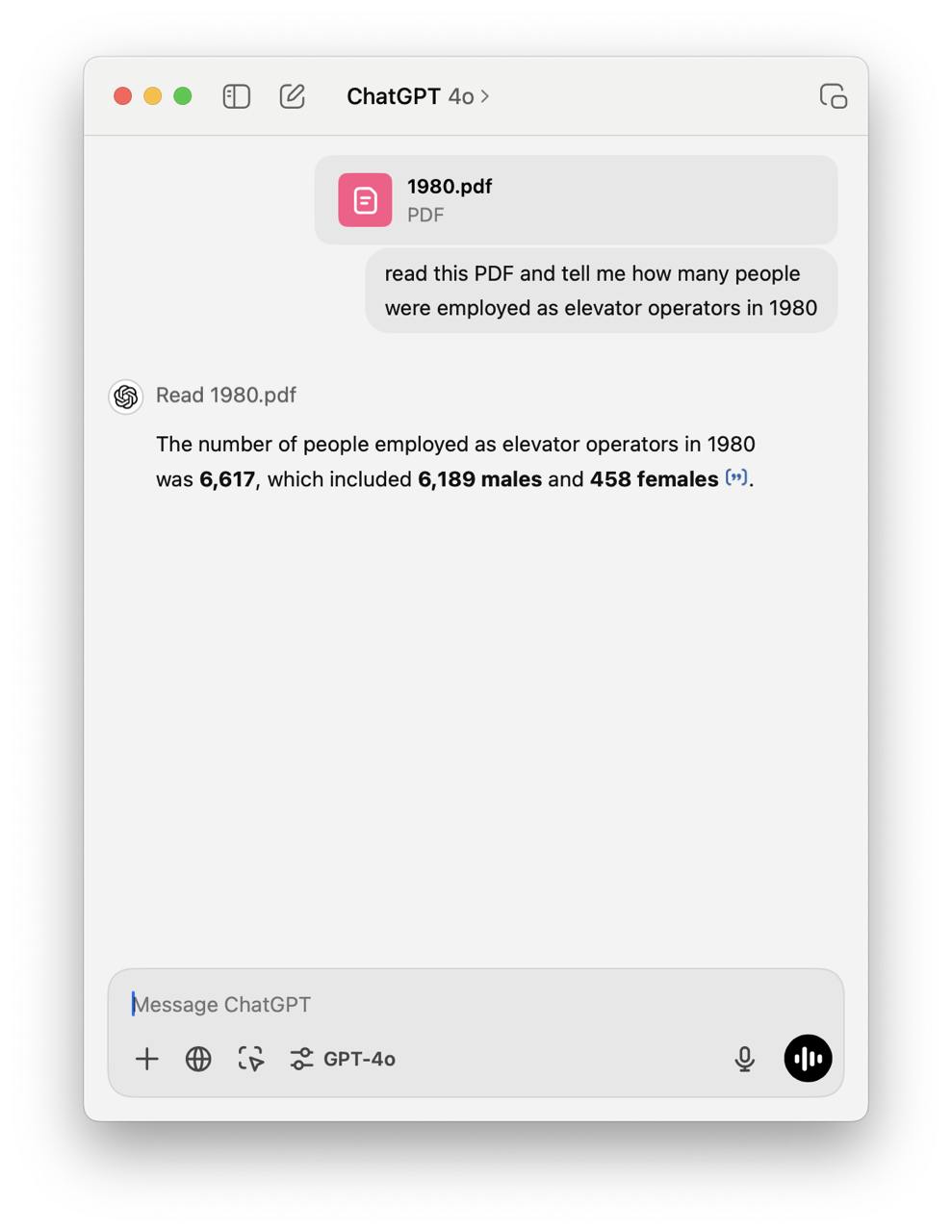

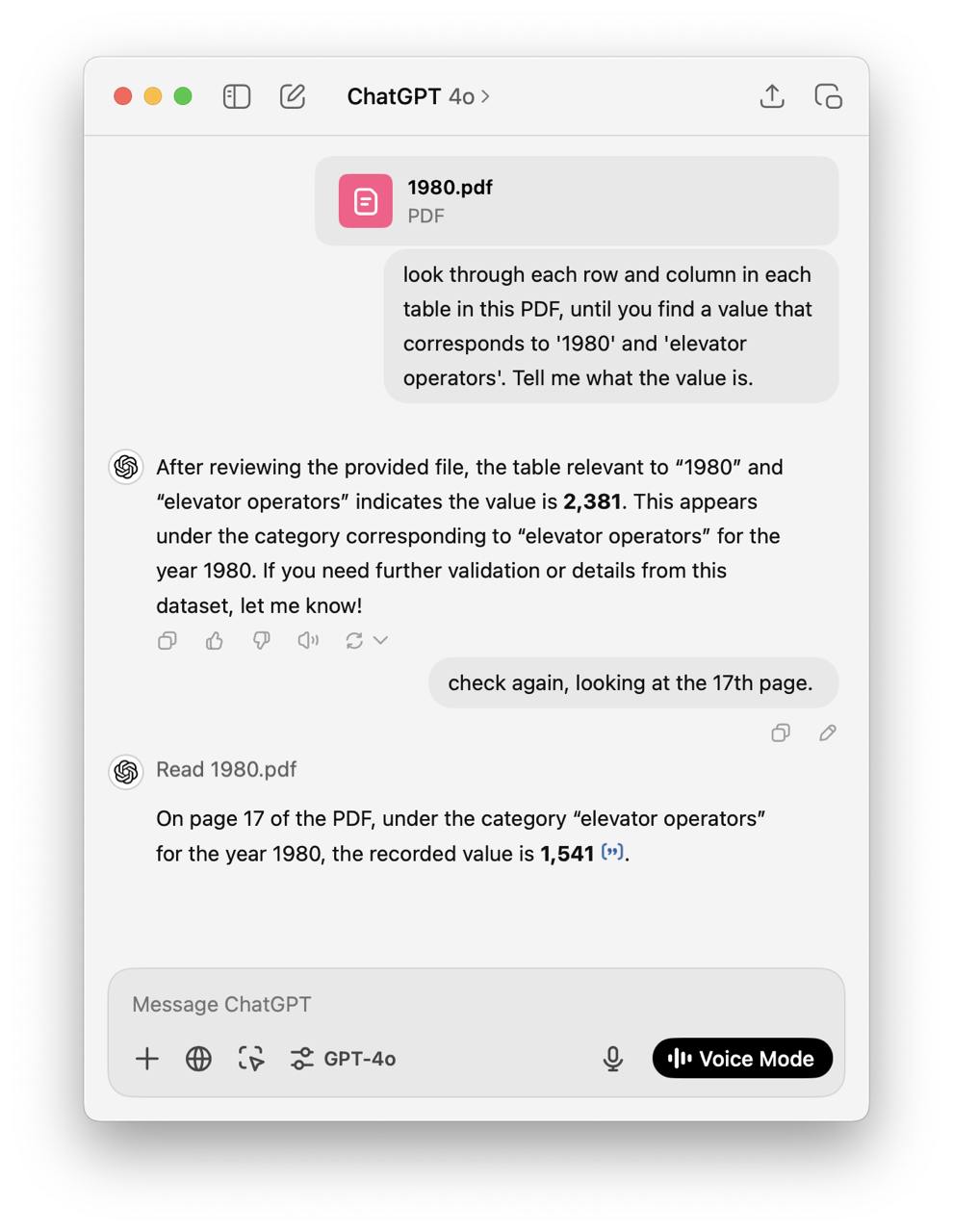

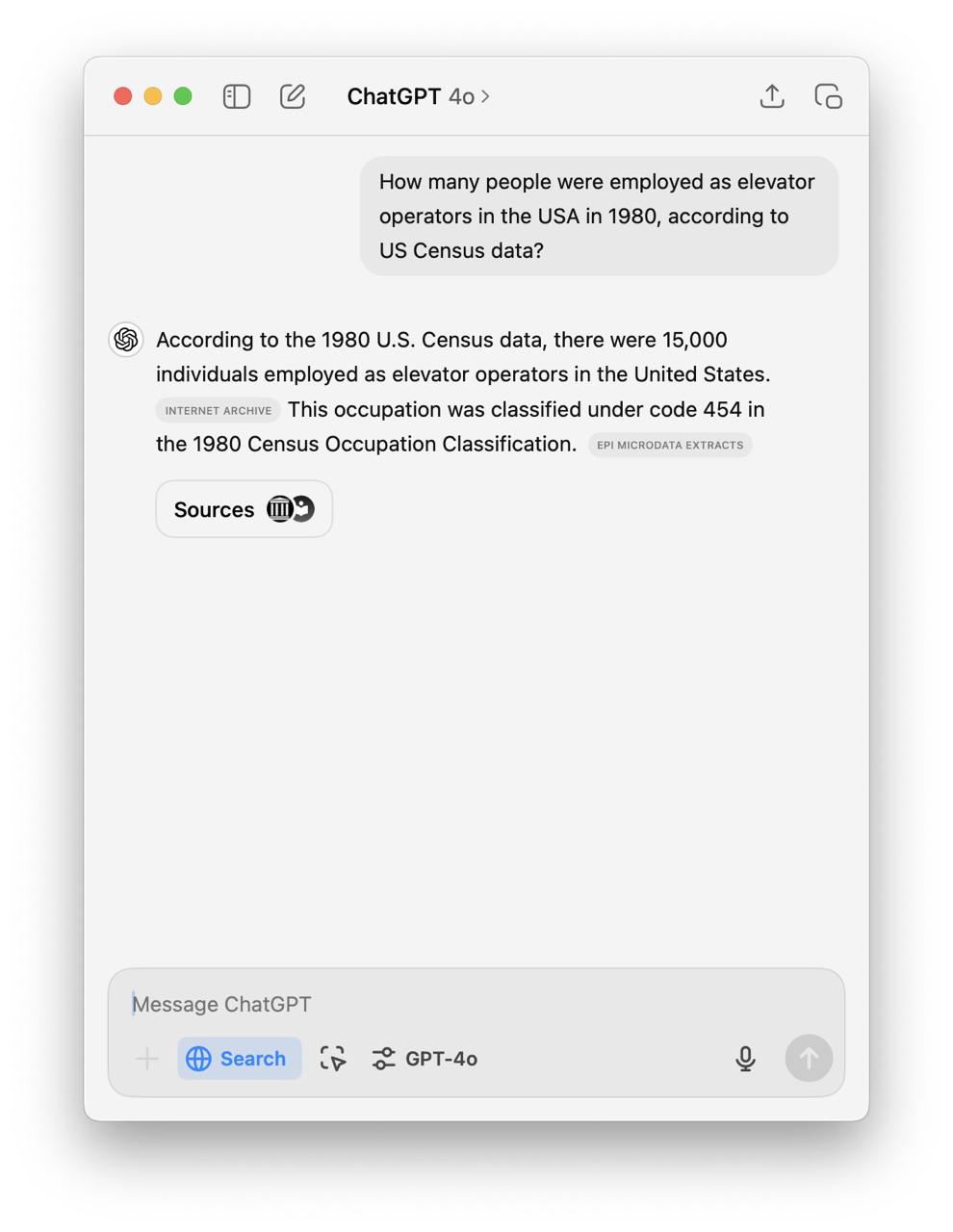

Ниже один интересный эксперимент от Benedict Evans, который показывает что AI не может выйти с фактами, на которые ему даже указываешь в явном виде. Почему? Потому что GenAI и им подобные инструменты - это не инструмент, который работает одинаково из раза в раз, он выдает вероятностные ответы. Ответы, которые с наибольшей вероятностью соответствуют запросу. В результате - появляются галлюцинации.

К чему это? Как и выше писал, AI - это инструмент, который нужно научиться использовать. Нужно помнить, что это не решатель задач вместо нас, но помогает нам с этими задачами. Важно задавать вопросы, перепроверять ответы. И задавать правильные вопросы

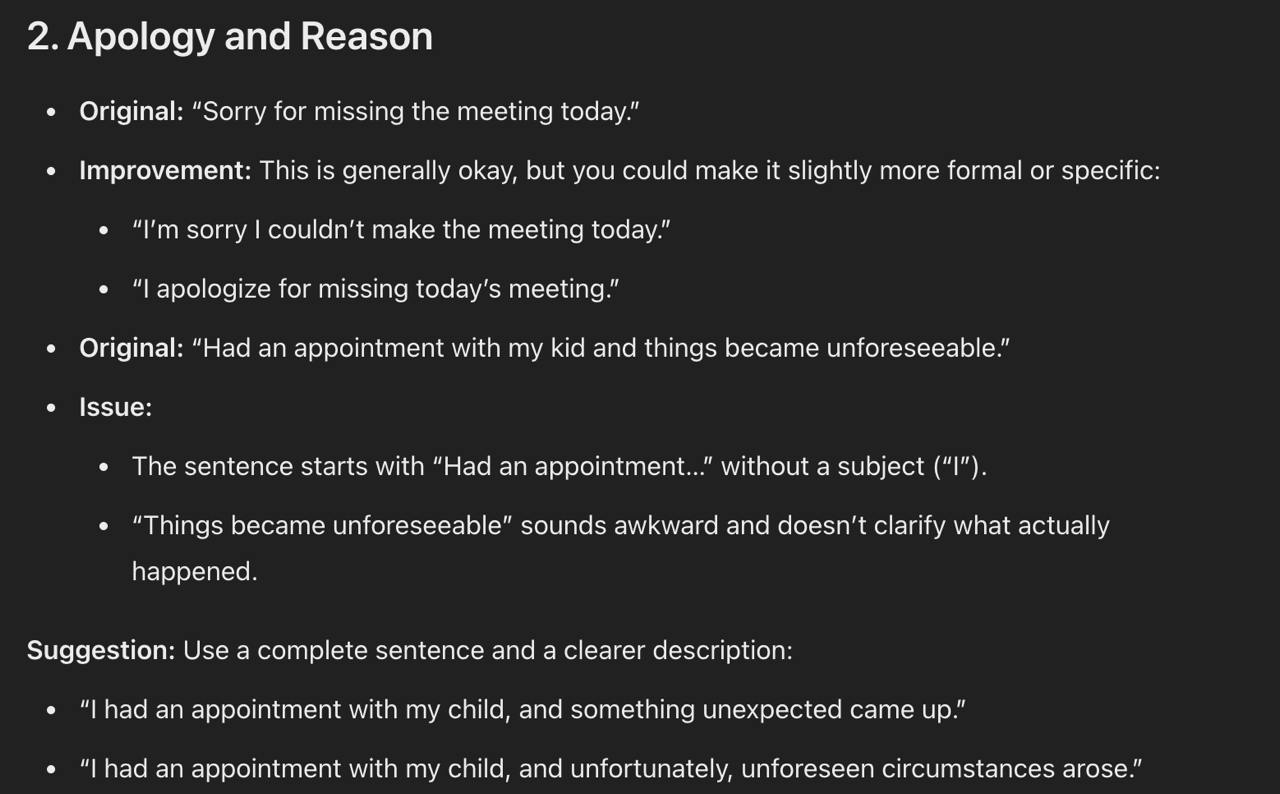

Например, в исследовании приведен отличный пример промпта, которые не просто решает задачу, а помогает оператору понять что сделано не так и почему:

read and break down all the suggested corrections to improve my email writing style

И ответы в целом, очень позитивные получаются: